- Khi định luật Moore không còn hiệu lực, ngành công nghiệp phải tìm ra những yếu tố mới thay cho tốc độ đơn thuần trong thiết kế bộ xử lý.

- Khi định luật Moore không còn hiệu lực, ngành công nghiệp phải tìm ra những yếu tố mới thay cho tốc độ đơn thuần trong thiết kế bộ xử lý. Nhìn về tương lai của kiến trúc CPU, các nhà quan sát ngành công nghiệp dù dự báo tích cực hay không đều có chung nhận định rằng, CPU sẽ không bao giờ trở lại thời huy hoàng đã qua với tốc độ xử lý tăng gấp đôi sau mỗi năm. Thực tế những năm gần đây cho thấy định luật Moore không còn phù hợp nữa, ngày càng khó thu nhỏ transistor để tăng gấp đôi số lượng trên chip sau mỗi chu kỳ 18 đến 24 tháng. (Chu kỳ này theo tiên đoán ban đầu của Moore là mỗi năm, về sau được nới rộng dần thành 18, 24 tháng). Công nghệ dường như đã chạm tới giới hạn vật lý. Kích thước transistor càng nhỏ, số lượng càng nhiều, chip chạy càng nhanh nhưng cũng nóng hơn.

Ngày nay, kỳ vọng tăng tốc độ xử lý vẫn còn nhưng xem ra khó có những thay đổi đột phá. Dù sao thì máy tính vẫn tiếp tục được cải tiến, tốc độ nhanh hơn, đem lại nhiều trải nghiệm phong phú hơn cho người dùng, giá ngày càng giảm và mọi người đều hài lòng.

Tốc độ không thể tăng mãi

Theo Tom Conte, cựu chủ tịch hiệp hội máy tính IEEE, toàn bộ vấn đề là ở tiêu hao năng lượng. Ông cho rằng rất khó để xử lý nhiệt lượng tỏa ra trên một centimet vuông từ thành tố có công suất không dưới 150 watt mà không cần đến giải pháp làm mát tốn kém. “Vì điện năng liên quan tới xung nhịp, chúng ta không thể cứ tăng xung nhịp bộ xử lý, bởi chip sẽ nóng hơn. Đó là vì sao ngành công nghiệp đã đưa vào nhiều nhân hơn với cùng tốc độ xử lý. Chúng có thể giúp tăng tốc máy tính của bạn khi nhiều chương trình chạy đồng thời, nhưng ít ai khai thác triệt để điều này”.

Cũng tán thành quan điểm tiếp cận đa nhân, nhưng chuyên gia phân tích Linley Gwennap tại The Linley Group, lại cho rằng hạn chế sẽ xuất hiện khi CPU đạt tới 8 nhân. “8 nhân xử lý song song là giới hạn, và khó có chương trình nào sử dụng hơn 3 hay 4 nhân xử lý. Do vậy chúng ta đã đâm đầu vào tường trong việc tăng tốc xử lý bằng đa nhân. Kiến trúc 64-bit cũng không giúp tăng thêm nhiều nhân xử lý. Các nhân xử lý kiểu Intel có thể thực thi cùng lúc 5 lệnh, và nhân ARM thì chỉ khoảng 3, nhưng vượt quá 5 là bắt đầu hiếm dần,và chúng ta cần kiến trúc mới để vượt qua điều đó. Điểm mấu chốt là phần mềm truyền thống sẽ không tăng tốc được mấy”.

Theo Conte thì ngành công nghiệp đã chạm tường từ những năm 1990 vì không giải quyết được vấn đề tiêu hao điện năng, dù các transistor đã trở nên nhanh hơn, và tốc độ xử lý của CPU đã tăng lên 2 hay 3 lần. Chúng ta đã phải sử dụng kiến trúc siêu vô hướng, và cuộc chơi đang phải dừng lại ở đó.

Thực tế là giải pháp đa nhân xuất hiện thay cho một nhân khi không còn hiệu quả vì khó tăng tốc độ lên mãi. Nhưng đối với các ứng dụng mang tính phổ biến, việc tăng tốc cho chúng không mấy được quan tâm, và nhiều chuyên gia tin rằng hướng phát triển trong tương lai là thiết kế kiến trúc CPU theo từng lĩnh vực. Nói cách khác, sẽ ngày càng xuất hiện nhiều bộ xử lý thực thi tác vụ chuyên biệt cho từng ngành hẹp, hoạt động hiệu quả hơn các bộ xử lý tiêu chuẩn.

Xu hướng này đang thể hiện rõ và tỏ ra hiệu quả trong lĩnh vực smartphone, do ARM Holdings dẫn dắt với những bộ xử lý ARM đang có mặt trong hầu hết các smartphone trên thị trường. Ian Smythe, giám đốc cao cấp tại ARM, ước tính rằng smartphone tiêu biểu ngày nay có từ 10 đến 20 nhân xử lý, bao gồm các nhân chạy hệ điều hành và ứng dụng. Ông cho biết kiến trúc big.LITTLE của ARM là kiểu tính toán không đồng nhất, trong đó các nhân tốc độ cao chạy những ứng dụng chính và nhân tốc độ thấp dành cho ứng dụng nền tiết kiệm năng lượng tối đa như quản lý năng lượng, cảm biến, kết nối không dây, quản lý màn hình cảm ứng và nhận diện dấu vân tay.

Theo Smythe, để tăng cường hiệu năng cần dời một khối lượng công việc ra khỏi CPU chuyển sang một bộ tăng tốc. Đó là cách ngành công nghiệp đã làm với bộ xử lý đồ họa và video, trong tương lai mạng nơ-ron có vẻ phù hợp với hướng đi này.

Nhiều chuyên gia cho rằng các bộ xử lý mạng nơ-ron sẽ ngày càng trở nên phổ biến, vì chúng có thể thúc đẩy nhanh xu hướng máy học (machine learning), nhận dạng ngôn ngữ tự nhiên và các kiểu trí tuệ nhân tạo (AI) khác.

Lấy ví dụ như bộ xử lý mới nhất của Wave Computing với 16.000 nhân. Ý tưởng ở đây, theo giải thích của giám đốc công nghệ Chris Nicol, là để tránh tiêu hao năng lượng cho việc chuyển dữ liệu vào/ra một CPU tiêu chuẩn, xử lý tuần tự.

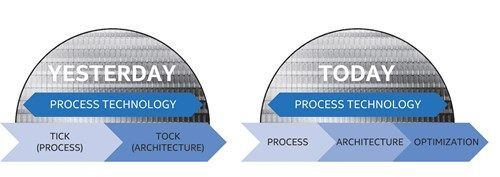

Intel đã thay chu kỳ phát triển CPU từ “tick – tock” 2 năm sang tiến trình dài hơn, trải qua 3 giai đoạn với khoảng 3 năm: “qui trình mới – kiến trúc mới – tối ưu hóa”.

“CPU được thiết kế sao cho kết quả tính toán của nhân này có thể được sử dụng cho phép tính của nhân khác trong chu kỳ tiếp theo”, Nicol nói. Ông gọi các kết quả là “tính toán không gian” và nói tiến trình có thể được hình dung như một mạng hai chiều, với thời gian là chiều thứ ba. Nicol cho biết, phiên bản cho người dùng cuối sẽ có vào cuối năm nay, và được dùng cho mạng nơ-ron chứ không phải là máy tính phổ dụng.

Sự lên ngôi của mạng nơ-ron đã được các chuyên gia dự đoán. David Patterson, giáo sư tại Đại học UC Berkeley, giải thích rằng một khi đã được huấn luyện, mạng nơ-ron có thể chạy trên điện thoại sử dụng bộ xử lý chuyên dụng, nhỏ hơn.

Về nhược điểm, bộ xử lý chuyên dụng chạy các phần mềm chuyên ngành đòi hỏi công cụ và trình biên dịch riêng. Giáo sư Krste Asanovic’ của Đại học UC Berkeley cho rằng, sự phát triển của CPU thực sự khủng khiếp từ quan điểm phần mềm, và mọi người chịu đựng nó lâu nhất có thể, nhưng hiện nay đó là con đường duy nhất.

Các framework lập trình chuyên dụng xuất hiện để mọi thứ đi vào trật tự, theo Steve Roddy, giám đốc công ty Cadence Design Systems chuyên về cung cấp giấy phép thiết kế bộ xử lý chuyên dụng. “Chúng cho phép các nhà lập trình viết code có thể độc lập với nền tảng và cho phép phân ra các nhà sản xuất áp dụng các cấp độ tài nguyên khác nhau. Mỗi nhà sản xuất chip phải quyết định cách hỗ trợ framework trên chip của họ. Như vậy, các nhà phát triển không nhất thiết phải biết mọi chi tiết để viết Angry Birds cho nhiều loại điện thoại”.

Patterson thì lưu ý một số framework chỉ dành cho mạng nơ-ron, như TensorFlow từ Google; Microsoft Cognitive Toolkit, hay CNTK; và MXNet của Amazon.

Thực thi ngôn ngữ trực tiếp

Framework sẽ không còn cần thiết nữa, và phần mềm có lẽ sẽ chạy nhanh hơn, nếu một bộ xử lý có thể thực thi trực tiếp các lệnh của một ngôn ngữ lập trình cao cấp hơn, kiểu như Java. Nhưng cho tới nay ý tưởng này chưa được chứng minh trên thực tế.

“Mọi người nỗ lực liên tục, nhưng tất cả đều thất bại thảm hại”, Jim Turley, nhà sáng lập Silicon Insider giải thích. Theo quan sát của ông thì 50% hay 75% giai đoạn đầu của dự án chip thường cho thấy triển vọng thực sự tốt, và các nhà đầu tư phấn khởi đổ tiền vào nhiều hơn. Nhưng rồi sau đó mọi thứ trở nên khó khăn, và kết quả là không nhanh hơn bao nhiêu. Do vậy, họ lần lượt thất bại.

“Các bộ xử lý hiện nay vốn được tối ưu hóa để chạy Linux và Windows nhanh nhất có thể, và không có phương pháp nào khả dĩ khiến chúng chạy nhanh hơn mà chưa được áp dụng”, Gwennap nhấn mạnh. “Linux và Windows là một đống code đồ sộ. Việc lập trình để tăng tốc chúng rõ ràng là quá phức tạp, do vậy chỉ còn cách thay thế mới hy vọng mọi thứ tốt lên được”.

Patterson bổ sung ý cho rằng trình biên dịch là ý tưởng tốt và cung cấp nhiều lợi thế.

Con đường lượng tử

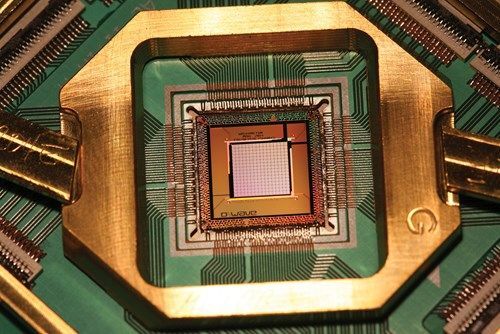

Nhiều nhà khoa học có chung nhận định, để tăng tốc độ có lẽ cách tốt nhất là đi theo hướng máy tính lượng tử. Cần phải dựa vào vật lý lượng tử để vượt qua những giới hạn vật lý của thế giới cổ điển vây quanh chúng ta. Họ đã đề xuất những cách thức tạo ra cổng logic dựa trên cơ học lượng tử và bằng cách đó cấu tạo nên bộ xử lý lượng tử phổ dụng. Nhưng nhà cung cấp máy tính lượng tử duy nhất trên thị trường là D-Wave Systems lại chưa làm được điều đó.

Mẫu máy tính lượng tử mới nhất của công ty có 2.048 qubit (bit lượng tử), xử lý không dựa trên các cổng logic nhị phân như với máy tính thông thường. Theo giải thích của Jeremy Hilton, phó chủ tịch cấp cao của D-Wave, nếu chúng ta tạo ra được các trạng thái chồng chập giữa các bit thì có thể thực hiện đồng thời các toán tử logic trên tất cả chúng. Hilton cho biết, quá trình này mất 5 micro giây. Và trong vòng 5 năm tới, máy tính lượng tử sẽ khá phổ biến trong các dịch vụ đám mây và các nhà phát triển có thể tiếp cận được chúng.

Chip lượng tử của D-Wave.

Tom Hackenberg, chuyên gia phân tích tại IHS Markit cho biết: “Công nghệ này sử dụng sự chồng chập và vướng víu lượng tử để đo lường khả năng kết hợp các bit. Khi bắt đầu có khả năng về mặt thương mại nó sẽ không nhắm vào tính toán truyền thống dựa trên bit (0 và 1) trong hệ nhị phân, mà được ứng dụng tuyệt vời chủ yếu cho deep learning và tính toán mạng nơ-ron”.

Theo Hilton, công nghệ lượng tử có thể được mở rộng cho tính toán phổ dụng, nhưng đó không phải là mục tiêu chính của D-Wave.

Bộ xử lý nguồn mở

Đổi mới triệt để là một động lực tuyệt vời đối với thị trường bộ xử lý đang bị thống trị bởi Intel, AMD (trên PC) và ARM (trên smartphone). Vấn đề là các công ty như Intel và ARM khó mà từ bỏ kiến trúc của họ, trong khi đó quá nhiều phần mềm rất khó cách tân ở cấp độ kiến trúc.

Chi phí phát triển cũng là một rào cản. Khi nói về chip, chúng ta thường đề cập tới kích thước ngày càng nhỏ theo các quy trình sản xuất 16, 14, 10, 7 và 5 nm, nhưng theo Asanovic’, điều nực cười là con số thực sự có ý nghĩa nằm ở số lượng khách hàng. Việc đầu tư xây dựng nhà máy fab hết sức đắt đỏ. Chi phí thiết kế khoảng 500 triệu USD, vì thế nhà sản xuất chip phải bán được số lượng lớn thì mới “ổn”.

Nhưng sự nổi lên của phần cứng bộ xử lý mã nguồn mở có thể mở ra cánh cửa cho những nhà tiên phong đổi mới, kiểu như những chàng trai khởi nghiệp từ gara ô tô.

Tổ chức RISC-V Foundation đã quảng bá RISC-V, một kiến trúc RISC (reduced instruction set computing) mã nguồn mở, 32, 64 hay 128 bit. Rick O’Connor, người đứng đầu tổ chức, giải thích rằng bộ xử lý RICS thế hệ thứ 5 miễn phí sử dụng cho mọi nhà cung cấp, nhưng họ phải trả phí để có chứng nhận (nếu muốn) và cấp phép nhãn hiệu. Kiến trúc cơ bản có ít hơn 50 chỉ thị phần cứng nhưng có thể được mở rộng theo mô-đun tới cấp độ máy chủ.

“Chúng tôi đã có 30 năm kinh nghiệm để tạo ra một tập lệnh hiệu quả”, O’Connor khẳng định.

SiFive ở San Francisco, Mỹ là nhà cung cấp silicon RISC-V đầu tiên. Jack Kang, phó chủ tịch của SiFive, cho biết rằng bằng việc sử dụng chip xử lý nguồn mở RISC-V và nhiều dạng thiết kế tự động khác, ông có thể cung cấp các mẫu 32-bit cho khách hàng với giá dưới 100.000 USD. Theo ông, mức giá đó thấp hơn so với các phương pháp thông thường, tạo điều kiện cho nhiều đối tác tiếp cận silicon RISC-V. RISC-V hấp dẫn vì miễn phí, mở, và thực sự khá tốt.

Việc hướng tới phần cứng nguồn mở có thể giúp giảm chi phí, như đã thấy trong ngành công nghiệp phần mềm từ lâu. Ngành công nghiệp phần cứng sẽ thúc đẩy công cuộc phát triển chip nhờ sử dụng nguồn mở. Nếu không, sẽ khó thoát ra ngoài cái vòng luẩn quẩn - khách hàng ít thì phải tăng giá bán, và giá cao lên lượng khách hàng lại càng ít.

Về cơ bản, không có lý gì bạn lại trả tiền cho một thứ trong khi vẫn có thể kiếm được cái khác cũng tốt mà không tốn tiền.

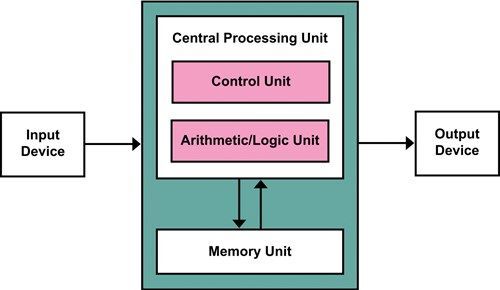

Von Neumann, bây giờ và mãi mãi

Những gì các nhà cách tân trong tương lai không nghĩ sẽ tạo ra là một bộ xử lý đi chệch cái gọi là kiến trúc Neumann. Cái tên này bắt nguồn từ một mô tả do nhà tiên phong máy tính John von Neumann viết vào năm 1945, trong đó ông đã phác thảo ra cấu trúc cơ bản cần có của một máy tính kỹ thuật số với chương trình được lưu trữ (stored-program).

Patterson khẳng định cấu trúc máy tính với sự kết hợp của các lệnh, bộ đếm chương trình, lệnh rẽ nhánh, các điều khiển vào/ra, tính toán số học như Von Neumann mường tượng ngay từ đầu sẽ không gì thay thế được, trừ khi rồi đây có ai đó tuyên bố rằng các tính toán ma trận (mạng nơ-ron) gắn với một cấu trúc mới.

Conte cũng cho rằng thay đổi may ra chỉ có thể diễn ra trong lĩnh vực phần mềm. Mọi người muốn có phần mềm đáng tin cậy, được chứng nhận, đã được kiểm thử, không có lỗi, nhưng cách chúng ta thực hiện lâu nay lại rất dễ đổ vỡ. Thậm chí các thuật toán cũng phải thay đổi. Tất nhiên máy tính truyền thống không mất đi ngay mà diễn biến trên thực tế cần có thời gian.

Patterson dự đoán trong vòng 10 năm tới máy tính để bàn hay tablet có thể vẫn sẽ dùng bộ xử lý tương tự như hiện nay cho hệ điều hành, nhưng sẽ có nhiều bộ xử lý chuyên dụng, cho ảo cảnh hoặc mạng nơ-ron hoặc (cho cái gì đó) chỉ có trời mới biết.

Theo nhận định của Roddy thì tới năm 2022 chúng ta sẽ chứng kiến sự chuyên môn hóa cao hơn nhiều và một lượng lớn hơn hẳn các hệ thống phân cấp chuyên dụng.

Smythe của ARM tiên đoán nếu tiếp tục sản xuất, CPU sẽ vẫn là thành tố quan trọng nhất vì nó là gốc của hệ điều hành. Theo ông, Von Neumann vẫn là khái niệm cốt lõi và chúng ta khó có thể thay đổi điều đó một cách đáng kể.

![[CES 2026] Spatial Signage - màn hình 3D không cần kính gây ấn tượng với độ mỏng và khung hình 85 inch](https://s-aicmscdn.nss.vn/thumb/100x100/nss-media/26/1/7/ces-2026--man-hinh-spatial-signage-danh-cho-quang-cao_695e232a438d4.png)